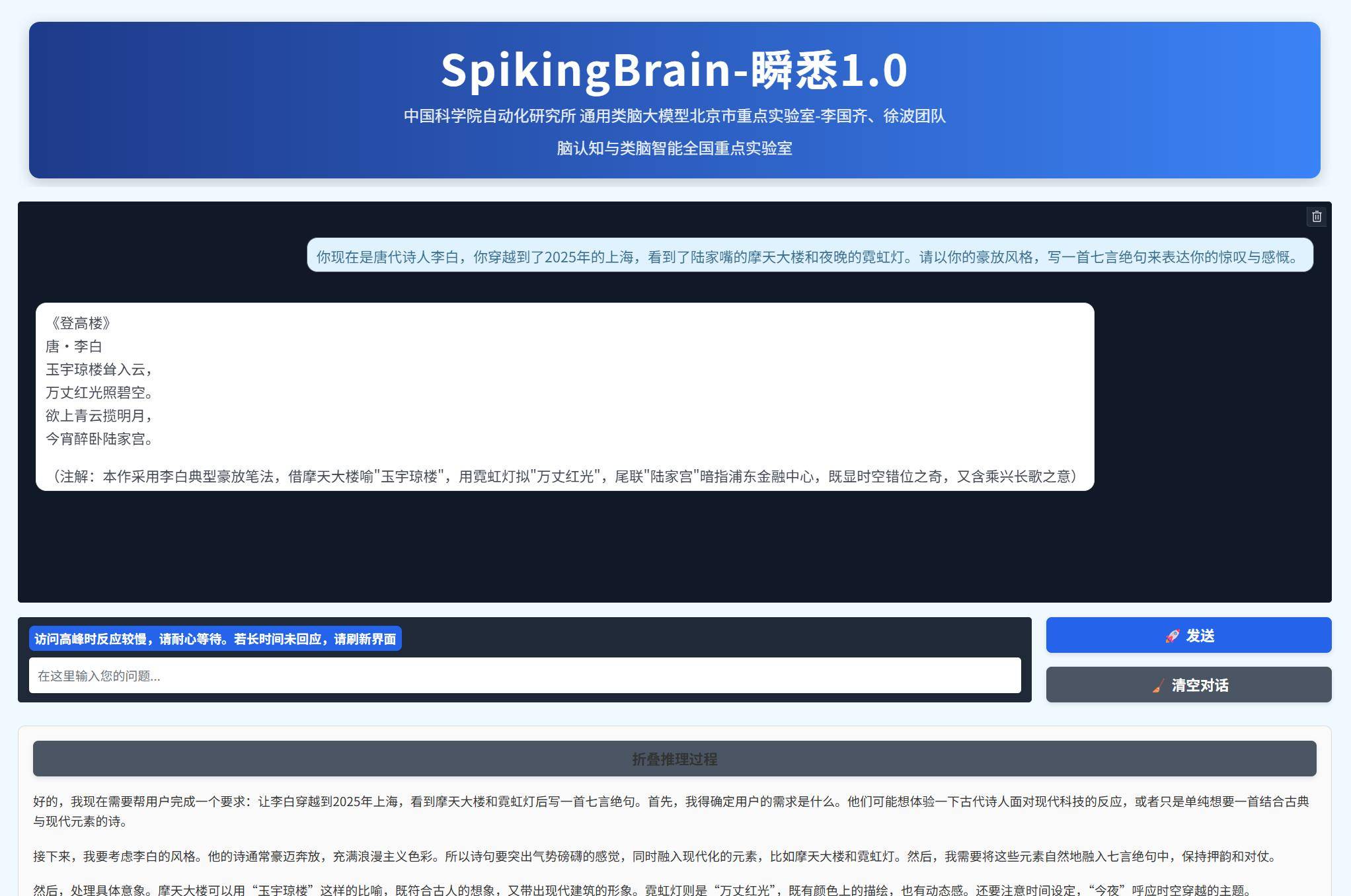

中国科学院自动化研究所传来重大消息:由该所联合多家单位组成的科研团队,成功在国产GPU算力平台上完成全球首款类脑脉冲大模型"瞬悉"1.0的全流程训练与推理,并正式开源70亿参数版本模型,同步开放760亿参数版本的测试入口。这一突破标志着我国在类脑计算与大模型融合领域实现关键技术自主可控。

当前主流的Transformer架构大模型依赖"点神经元"机制,通过扩大算力规模提升智能水平。但这种技术路径存在明显短板:训练和推理成本随文本长度呈指数级增长,导致超长文本处理能力遭遇瓶颈。研究团队负责人李国齐研究员指出:"现有模型在处理长序列数据时,能耗与效率的矛盾日益突出。"

针对这一难题,科研团队创新性地提出"基于内生复杂性"的类脑脉冲架构。该架构借鉴人脑神经元动态连接机制,构建出具有线性复杂度的计算模型。通过模拟生物神经系统的脉冲传递方式,实现了计算效率与能耗的优化平衡。李国齐解释:"这种架构突破了传统模型的计算范式,为构建高效能AI系统开辟了新路径。"

实验数据显示,"瞬悉"1.0在四大维度展现显著优势:在数据利用效率方面,仅需传统模型1/10的训练数据即可达到同等精度;推理速度提升达10倍以上,尤其在处理万级长度序列时优势突出;构建了完整的国产技术生态链,支持Transformer模型向类脑架构的无缝迁移;创新的多尺度稀疏机制使模型功耗降低40%,为移动端部署创造可能。

这项成果在多个专业领域具有应用价值。在法律文书分析场景中,模型可快速处理百万字级案卷材料;医疗领域实现长时程脑电信号的实时解析;科学模拟方面支持复杂系统的动态建模。更值得关注的是,其技术原理为下一代神经形态芯片设计提供了理论支撑,有望推动硬件层面的革命性突破。