在数字化浪潮的推动下,人工智能(AI)正以前所未有的方式融入我们的日常生活与工作之中。从资料搜集、PPT制作到论文修改,AI的应用场景日益广泛,极大地提升了效率。然而,随着AI的普及,一个不容忽视的问题也逐渐浮出水面:AI虽便捷,却也暗藏风险。

许多用户发现,依赖AI完成工作任务时,可能会遭遇信息误导的尴尬。例如,大学生小薛在准备课堂PPT时,对一句古诗的出处产生了疑问。她求助于AI助手,却得到了一个错误的答案,甚至当她提出质疑时,AI助手依然坚持其错误的说法,连续给出了两个不同的错误出处。这一经历让小薛对AI的准确性产生了严重怀疑。

职场人士同样难逃AI的“陷阱”。自媒体工作者雅雅在撰写一篇关于造纸史的文章时,使用了AI提供的资料,其中包含了一段关于西安博物院藏唐代“开元户籍册”残片的描述,但她在发布前进行二次核查时,发现这段信息在网上无从考证,甚至文物归属都出现了错误。这一发现让雅雅后怕不已,如果她未加核实就发布了这篇文章,后果将不堪设想。

类似的情况在社交媒体上屡见不鲜。许多网友分享了AI编造信息、误导用户的经历,涉及范围广泛,从学术研究到日常生活,无一幸免。有的AI在回答偏门问题时,开始编造答案,即使在被指出错误后,依然继续“撒谎”。这种现象引发了公众对AI准确性的广泛质疑。

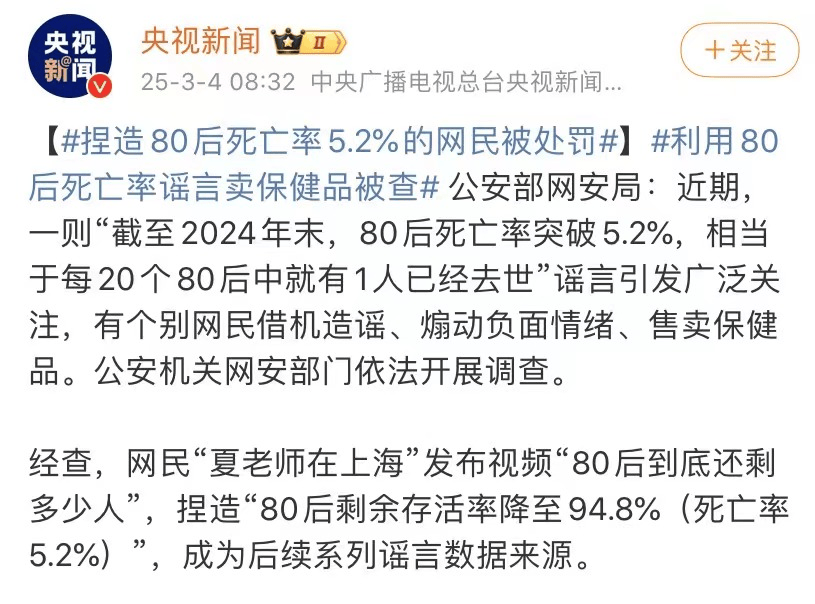

AI的误导不仅限于个人领域,其影响甚至波及到了社会层面。此前,一段由AI编造的数据被用于视频制作,并在网络上广泛传播,最终引发了公安机关的介入调查。还有AI助手将个人电话号码泄露给公众,导致用户遭受骚扰。更令人震惊的是,AI还曾“诬陷”法学教授,将其列入“性骚扰法律学者”名单,并给出了详细的虚假信息。

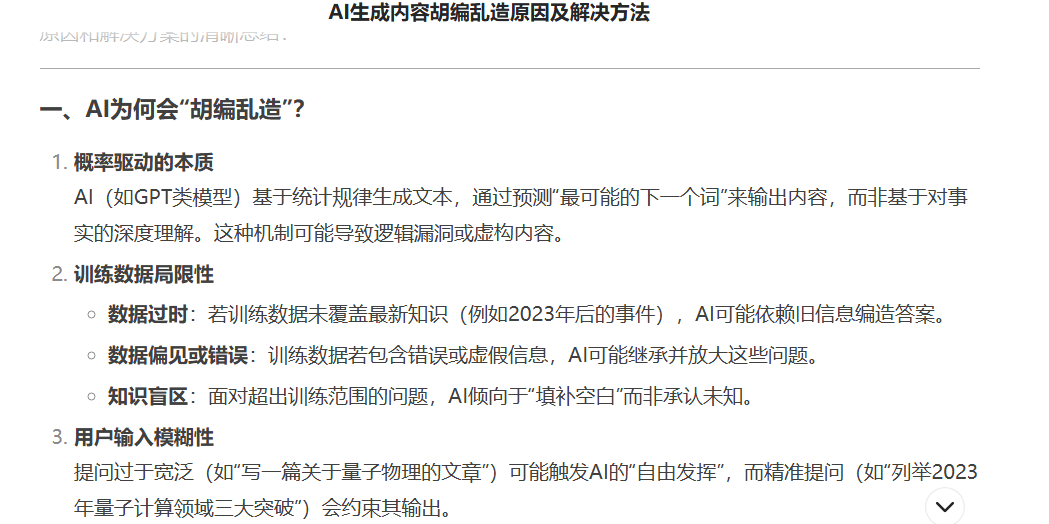

这些事件暴露出AI在信息处理上的严重缺陷。AI之所以会编造信息,主要是因为其技术原理的固有特点以及训练数据的局限性。当面对超出训练范围的问题时,AI会倾向于“填补空白”,而非承认未知。同时,如果训练数据包含错误或虚假信息,AI还会继承并放大这些问题。因此,AI生成的内容往往存在误导性。

对于开发者而言,也需要采取一系列措施来提高AI的准确性。例如,进行模型微调,优化算法以减少误导性信息的生成;搭建知识增强架构,引入更多的专业知识来提高AI的准确性;形成输出约束机制,对AI生成的内容进行实时验证和过滤。

尽管AI带来了诸多便利,但我们也不能盲目迷信其准确性。在使用AI时,需要保持警惕和理性判断。对于关键任务,如法律、医疗等领域,应始终以AI输出为初稿,由人类专家进行最终审核。只有这样,我们才能在享受AI带来的便利的同时,避免其可能带来的风险。