在人工智能领域的一次重大突破中,智源研究院于2025年6月6日在北京成功举办了第七届智源大会,会上震撼发布了“悟界”系列大模型。这一系列模型标志着智源研究院在探索多模态、脑科学、具身智能以及微观生命分子建模四大核心方向上迈出了坚实的步伐。

自2018年成立以来,智源研究院作为中国新型科研机构的典范,不仅开辟了国产大模型的技术新路径,还激发了中国AI大模型创业生态的首波热潮。众多初创公司如雨后春笋般涌现,其中不乏由杨植麟、岂凡超、曾国洋等曾在“悟道1.0”与“2.0”项目中历练成长的新一代AI创业者,他们已成为中国AI大模型领域的中坚力量。

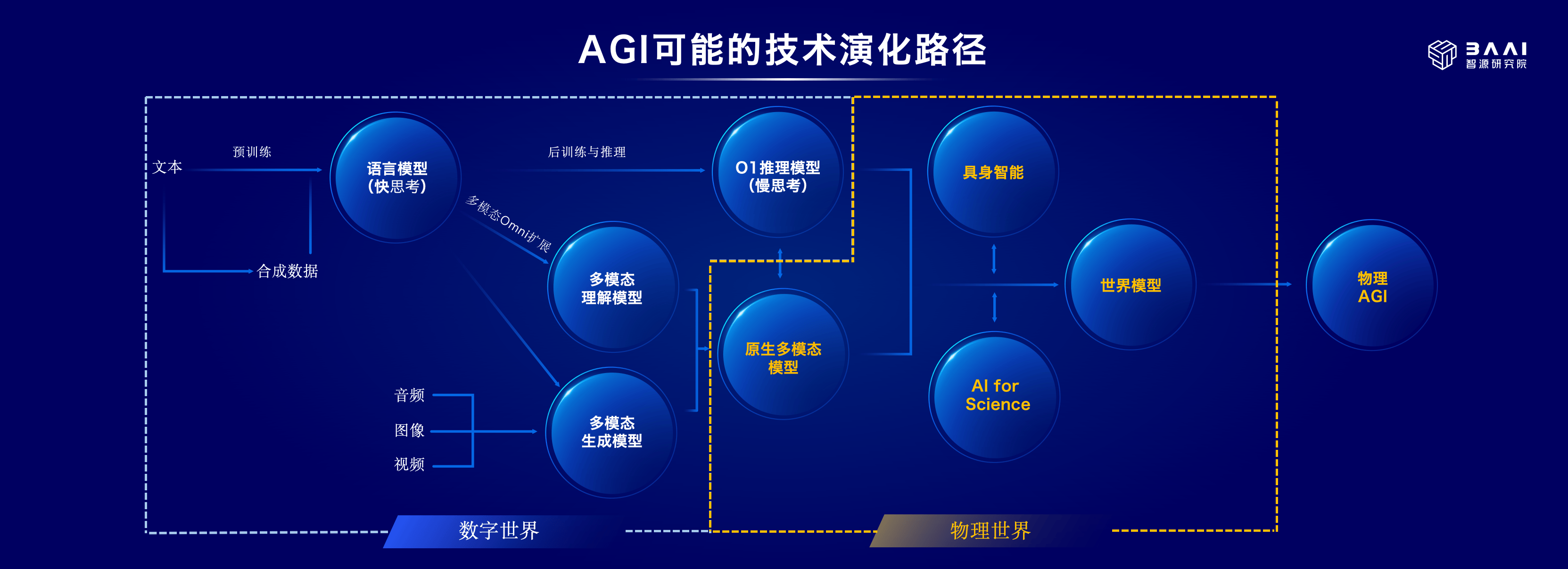

“悟界”系列模型的发布,是智源研究院在“悟道”之后的又一里程碑。与以往聚焦于数字世界的语言、图像等不同,“悟界”将探索的触角延伸至真实世界的感知、决策与交互,旨在突破虚实世界的边界,赋能物理世界,并向物理AGI(通用人工智能)迈进。

智源研究院院长王仲远在接受专访时,深入阐述了“悟界”背后的研究逻辑、技术布局与未来方向。他提到,“悟界”系列涵盖了原生多模态世界模型Emu3、脑科学多模态通用基础模型见微Brainμ、跨本体具身大小脑协作框架RoboOS 2.0与具身大脑RoboBrain 2.0以及全原子微观生命模型OpenComplex2,几乎囊括了当前AI与人类核心认知结构、现实物理世界交互及生命本质建模的所有前沿探索。

王仲远指出,当前大语言模型的发展已遭遇瓶颈,互联网数据趋于饱和,模型性能提升缓慢,且多模态融合存在“此消彼长”的问题。为了突破这一困境,“悟界”系列引入了更多真实世界的信息,如图像、声音、三维空间结构乃至人脑活动信号,探索“原生多模态”的新方法,使AI从一开始就具备综合理解各种信息的能力。

Emu3作为原生多模态世界模型的代表,能够将文字、图片、视频转化为同一种“语言”处理,从而更顺畅地理解和生成不同形式的内容。同时,见微Brainμ模型能将脑信号转化为模型可处理的“语言”,并与图像和文本进行跨模态多向映射,进一步拓宽了AI的应用边界。

王仲远还强调,未来大模型需要具备对空间位置和时间变化的感知能力,这对于AI机器人在现实中完成任务至关重要。他认为,面向物理世界的原生多模态模型将是实现真正“物理AGI”的路径之一。

在具身智能领域,王仲远表示,尽管该技术仍处于探索早期,类似于大模型在GPT-3之前的阶段,但已吸引了众多创业公司的关注。然而,具身智能仍面临多重挑战,包括核心技术路径不明确、数据采集困难以及软硬件协同复杂等。

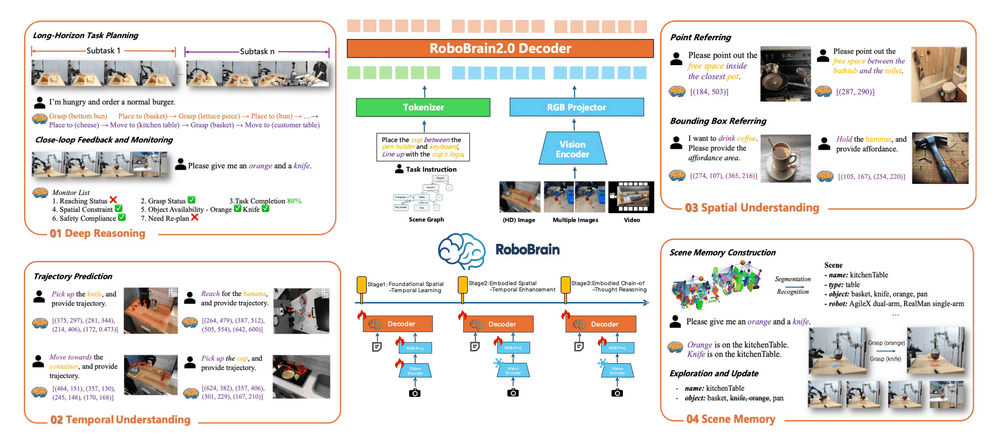

为了推动具身智能的发展,智源研究院发布了全球最强的开源具身大脑大模型RoboBrain 2.0,并在多项空间推理与任务规划指标上超越了主流大模型。同时,他们还推出了跨本体具身大小脑协作框架RoboOS 2.0,这是全球首个基于具身智能的SaaS平台,旨在构建具身智能领域的“应用商店”生态。

RoboOS 2.0实现了小脑技能的免适配注册机制,显著降低了开发门槛,使得开发者能够更容易地贡献和分享小脑技能。目前,RoboOS 2.0与RoboBrain 2.0已全面开源,并与全球20多家具身智能企业建立了战略合作关系。

对于具身智能的未来发展趋势,王仲远认为,虽然大规模商用落地尚需时日,但在未来三年内,突破性的规模化应用最有可能首先出现在特定且相对封闭的场景中,尤其是那些需要大量重复、枯燥甚至危险任务的领域。