在近日的一场行业交流活动中,范式智能CEO戴文渊发表了关于国产算力生态建设的深度演讲。他指出,当前中国AI产业面临一个关键矛盾:尽管国内AI应用数量已达数千个,但99%以上的工作仍依赖于英伟达的技术体系,国产信创生态尚未形成有效支撑。

戴文渊以手机应用生态作比:若苹果手机拥有200万个应用,而国产手机仅有50个可用应用,用户根本不会考虑性能差异就会直接放弃使用。这种生态差距在GPU领域同样存在——英伟达CUDA体系拥有1.8万个算子,而国产GPU平均仅有几百个,核心数量相差20倍。更严峻的是,多数商业开发者面临"用不掉一张卡"的困境,头部企业追求万卡集群的同时,中小企业更需要"一张卡跑万个模型"的解决方案。

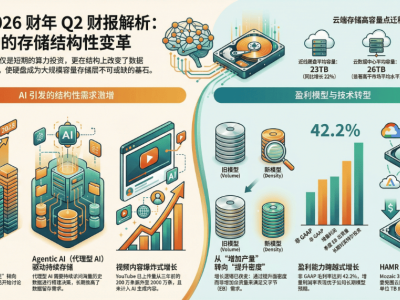

针对利用率痛点,范式智能推出信创魔盒Model Hub XC平台,致力于打造国产大模型社区。该平台自去年9月发布以来,模型数量已突破1万个,上周单周适配量达2500个。戴文渊透露,按照当前增长速度,今年有望实现10万级模型储备,明年追平英伟达社区规模。这个被称作"信创版Hugging Face"的平台,专门适配国产GPU环境,与单纯复制国际生态的"中国版Hugging Face"形成本质区别。

在技术架构层面,范式智能构建的Honey社区VGPU平台已形成全球最大异构计算社区,支持英伟达与国产GPU混合部署。其最新推出的Fancy Cloud云服务,集成了VGPU技术与开发平台,当前可提供超万个国产模型调用,今年计划将模型数量提升至10万级。该平台特别整合了范式智能在20多个行业积累的垂直模型能力,形成从通用到专业的完整解决方案。

戴文渊特别强调性价比突破的关键性。他表示,国产GPU销量增长主要源于安全性需求,而非性能优势。随着曦望科技发布启望S3芯片,提出"百万token一分钱"计划,国产算力首次展现出成本竞争力。范式智能将与曦望合作打造Fancy Cloud算力云,通过软件优化与硬件创新结合,推动中国算力成为全球最廉价的选择。这场合作不仅解决安全顾虑,更致力于建立覆盖全行业的国产技术生态。