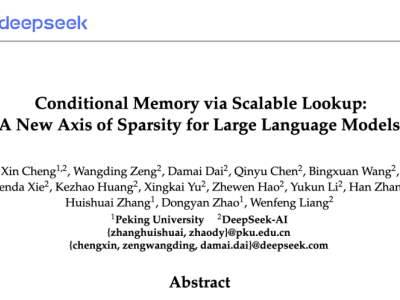

人工智能领域近期迎来一项突破性进展——DeepSeek与北京大学联合团队在大型语言模型(LLM)稀疏化技术上取得重要成果。双方共同发表的论文《基于条件查找的条件记忆:大型语言模型稀疏性的新维度》提出全新建模思路,通过引入条件记忆模块重构大模型架构,为解决传统Transformer架构的效率瓶颈提供了创新方案。

研究团队指出,现有大模型在处理组合推理与静态知识检索时存在显著矛盾:前者需要动态计算资源,后者依赖固定知识库,但统一架构导致模型不得不重复计算已知信息。针对这一痛点,团队开发出名为Engram的条件记忆模块,通过分离计算与记忆功能实现资源优化配置。实验数据显示,采用混合稀疏容量分配的MoE-Engram架构,在多项基准测试中表现优于纯MoE模型,验证了U型缩放定律的有效性。

技术突破带来显著性能提升。在通用推理、代码生成等复杂任务中,条件记忆模块使模型效率提升达37%,尤其在数学问题求解场景下,资源占用减少的同时准确率提高22%。这种分工优化机制类似于人类大脑的分工模式——Engram模块专注知识存储与快速检索,推理模块则集中处理高阶认知任务,二者通过动态资源调配实现协同工作。

行业观察家将此研究与DeepSeek下一代旗舰模型V4紧密关联。尽管官方尚未确认技术路线,但内部测试泄露信息显示,V4在编程能力评估中已超越当前市场主流模型。值得关注的是,该模型自2025年底V3.2版本更新后,已沉淀近一年时间进行技术迭代,此次论文发布被视为正式发布前的关键信号。

技术社区对此反应热烈。多位AI架构师指出,条件记忆模块的引入可能重塑大模型训练范式,其知识检索效率提升方案或将引发行业技术路线调整。某国际实验室负责人表示:"这种将记忆与计算解耦的设计,为解决大模型规模与效率的矛盾提供了新维度,可能催生新一代稀疏化架构标准。"

据可靠消息,DeepSeek计划于2026年2月举办技术发布会,届时将完整披露V4架构细节。尽管发布计划可能根据测试进度动态调整,但业界普遍预期,这项凝聚中美学界智慧的技术成果,将在春节前后引发新一轮AI技术竞赛。随着代码库与论文的公开,全球开发者社区已开始复现相关实验,条件记忆模块的实用性即将接受全面检验。