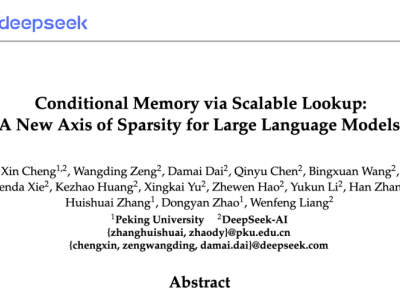

近日,人工智能领域迎来一项重要研究成果——DeepSeek联合北京大学发布新论文《Conditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models》,该研究为大语言模型的发展开辟了新方向。论文由DeepSeek创始人梁文锋参与署名,相关代码及论文已在GitHub平台开源。

当前,混合专家(MoE)范式是大语言模型中主流的条件计算方式,它通过条件计算有效扩展了模型容量。然而,Transformer架构本身缺乏原生的知识查找机制,模型不得不通过动态计算来模拟静态知识的检索,这造成了资源利用的低效。针对这一问题,该论文提出了“条件记忆”这一全新概念,将其作为补充现有稀疏性维度的新方向。

为实现“条件记忆”,研究团队引入了Engram模块。此模块基于经典的N - gram嵌入思想进行现代化改造,支持可扩展的O(1)查找,专门用于存储和检索静态的语言模式,像命名实体、习惯用语等。通过形式化“稀疏分配”问题,研究发现了U形缩放定律。该定律表明,在MoE专家和Engram内存之间合理分配稀疏容量,能够使模型取得最优性能。

基于这一发现,研究团队将Engram扩展至270亿参数规模。在多个基准测试中,Engram模型显著超越了同参数、同计算量的MoE基线模型。不仅在知识检索任务(如MMLU、CMMLU)上表现出色,在通用推理(如BBH、ARC - Challenge)以及代码和数学推理(如Humaneval、MATH)等领域也带来了更大的增益。

机制分析显示,Engram通过将静态模式的重建任务从早期层卸载,有效增加了网络可用于复杂推理的“深度”,同时释放了注意力机制处理全局上下文的能力,从而显著增强了长上下文性能(如LongPPL和RULER测试)。Engram的确定性寻址机制允许在系统层面实现存储与计算的解耦,支持将庞大的参数表卸载到主机内存,且推理开销极低,体现了基础设施感知的高效设计。

除论文本身外,相关完整文档也已上传至特定平台,包括《DeepSeek论文 - 基于可扩展查找的条件记忆:大语言模型稀疏性的新维度(中文)》《DeepSeek论文 - 基于可扩展查找的条件记忆:大语言模型稀疏性的新维度(英文)》。同时,还有《2025中央企业高质量数据集建设研究报告》《开源大模型法律风险及防范研究报告(2025)》等资料可供查阅。