近日,字节跳动旗下的豆包大模型团队宣布了一项针对混合专家(MoE)架构的重要技术突破,并宣布将此关键技术优化方案开源。据官方介绍,这项技术能显著提升大模型的训练效率,最高可达1.7倍,同时降低训练成本40%。

据悉,该优化技术已在字节跳动的万卡集群训练中得到了实际应用,成功节省了数百万GPU小时的训练算力资源。这一成果不仅体现了字节跳动在大模型技术领域的深厚积累,也为其在全球范围内的技术竞争增添了新的筹码。

值得注意的是,这项技术还入选了全球机器学习系统顶级会议MLSys 2025,并以高分获得了评审专家的高度评价。MLSys 2025认为,该技术在解决大规模生产环境中的实际问题方面具有极大的应用潜力。

MoE架构作为当前大模型的主流选择,虽然在性能上表现出色,但在分布式训练中却面临着巨大的通信开销问题。以海外知名的Mixtral-8x7B模型为例,其训练过程中的通信时间占比高达40%,严重制约了训练效率和成本控制。针对这一难题,字节跳动内部研发了名为COMET的计算-通信重叠技术,通过一系列创新手段,有效降低了MoE专家通信的空转时间。

与近期DeepSeek开源的DualPipe等MoE优化方案相比,COMET具有更高的灵活性和兼容性。它像插件一样可以直接接入现有的MoE训练框架,无需对框架进行大规模的改动,从而支持了业界绝大部分主流大模型。COMET还支持多种MoE并行模式,部署方便,为开发者提供了一套友好的Python API。

COMET与DeepSeek的DualPipe方案还可以联合使用,进一步降低MoE的通信开销。COMET通过计算-通信融合算子的优化方式,减少了通信时间;而DualPipe则通过巧妙的算子排布来掩盖通信延迟。两者结合使用,有望更大幅度地压缩模型训练成本。

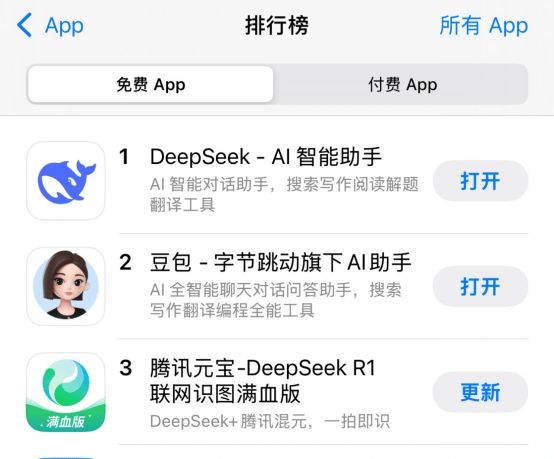

在国内大模型研发技术快速发展的背景下,相关应用的下载量也呈现出快速增长的趋势。据最新数据显示,DeepSeek在中国区苹果应用商店免费APP下载排行榜上位居榜首,豆包紧随其后排在第二位,而腾讯的元宝则位列第三。这一排名不仅反映了各家大模型技术的实用能力,也预示着未来市场竞争的激烈程度。

然而,近期也有关于字节跳动的市场传言引发关注。有消息称,字节跳动已向寒武纪下单4万颗580芯片,总价值高达10亿元。但对此传言,字节跳动相关负责人迅速进行了辟谣,表示消息不实。

还有消息称国内创业公司Monica开发的Manus大模型曾婉拒了字节跳动的投资。据报道,Monica在2024年初曾与字节跳动进行过一轮收购谈判,但因价格未达预期而未能达成协议。接近Monica内部的从业者透露,字节跳动的收购计划主要是看重Monica的团队和技术,但Monica创始人肖弘担心被收购后会丧失产品上的独特优势,因此选择了拒绝。目前,Monica的估值已接近1亿美元。

另一方面,有关抖音将接入豆包大模型的消息也引起了广泛关注。据称,抖音App正在测试将豆包的AI能力直接嵌入其中,为用户带来更加丰富多元的智能体验。在测试版本中,抖音为豆包开放了两个重要入口,分别置于短视频界面和消息列表内,使用户无需跳转即可直接使用AI服务。这一举措不仅将强化抖音自身的AI能力,还能通过庞大的用户基数为豆包导流,推动AI生态闭环的建设。