在中国杭州,一家名为DeepSeek的初创企业如同一条搅动水面的鲶鱼,给全球大模型生态带来了前所未有的活力。自蛇年春节以来,围绕“接入DeepSeek”的竞赛在中国AI行业如火如荼地展开,短短一个多月,从芯片制造商、云服务提供商、算力服务商到软件开发商,再到各类面向终端用户的硬件制造商,超过百家中国公司已宣布加入DeepSeek的合作伙伴网络,借助其开源模型能力,拓展自身的业务版图。

DeepSeek不仅极大地推动了大模型的普及,还引发了对算力的热烈讨论。市场对此的态度经历了剧烈波动:起初,DeepSeek的低算力成本特性一度冲击了英伟达等算力巨头的股价;随后,随着用户访问量的激增和私有化部署需求的增长,算力概念股又强势反弹,供不应求。最近,DeepSeek还公布了其理论成本和利润率,再次在AI圈内引发热议。

随着DeepSeek合作伙伴网络的不断扩大,由OpenAI引发的芯片硬件侧的军备竞赛能否持续?这场算力游戏又将带来哪些新的规则?DeepSeek的“朋友圈”中,各类参与者各怀心思。DeepSeek以其低成本、高性能著称,根据官方数据,每个H800节点每秒能处理73.7k/14.8k个输入/输出tokens,理论单日总收入高达562027美元,成本利润率高达545%,其“中国式创新”激活了国产算力生态。

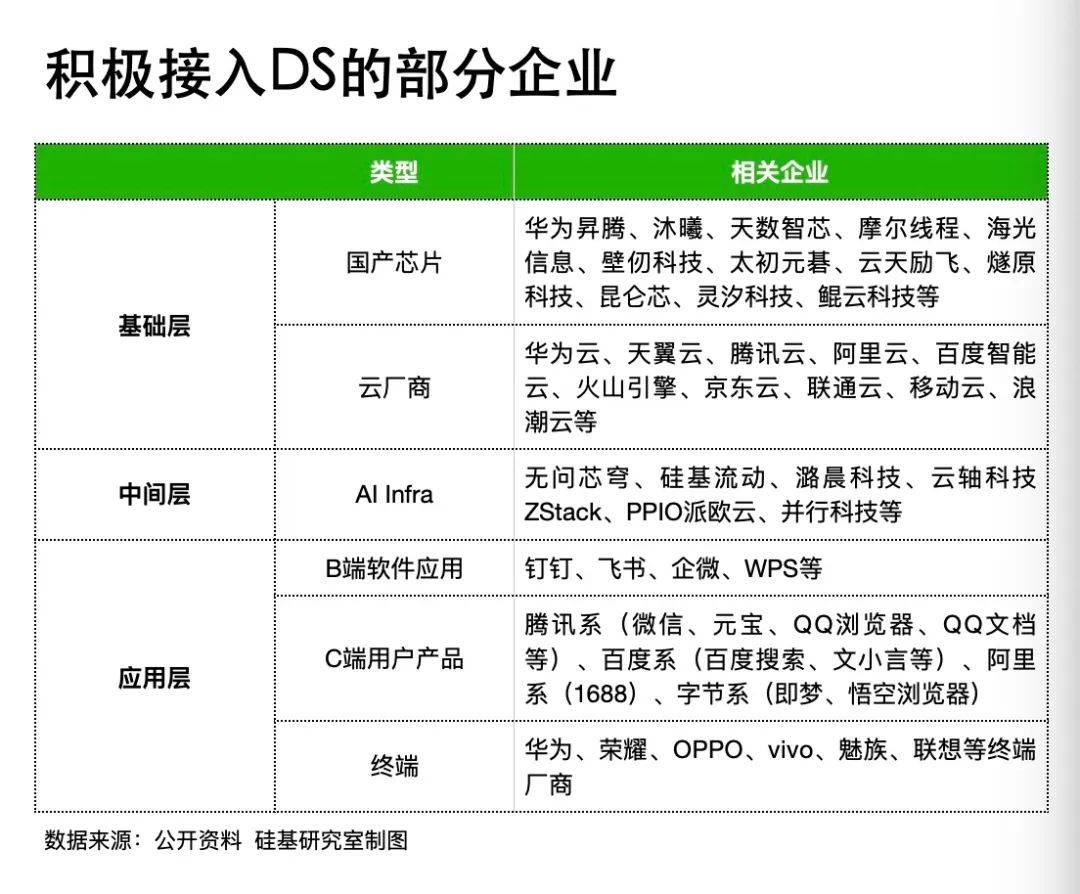

在DeepSeek的合作伙伴中,表现最为积极、行动最快的可以分为四类:基础层(包括国产芯片制造商、云服务提供商)、中间层(AI基础设施提供商)以及在B端和C端的软硬件制造商。据不完全统计,第一批接入DeepSeek的企业就近百家。

“每天都有十几个咨询,从春节复工后就没休息过。”一位AI基础设施提供商的商务人员表示。作为连接大模型底层算力和下游应用的中间层,AI基础设施提供商既是第一批接住DeepSeek“流量”的玩家,也是第一批受益者。

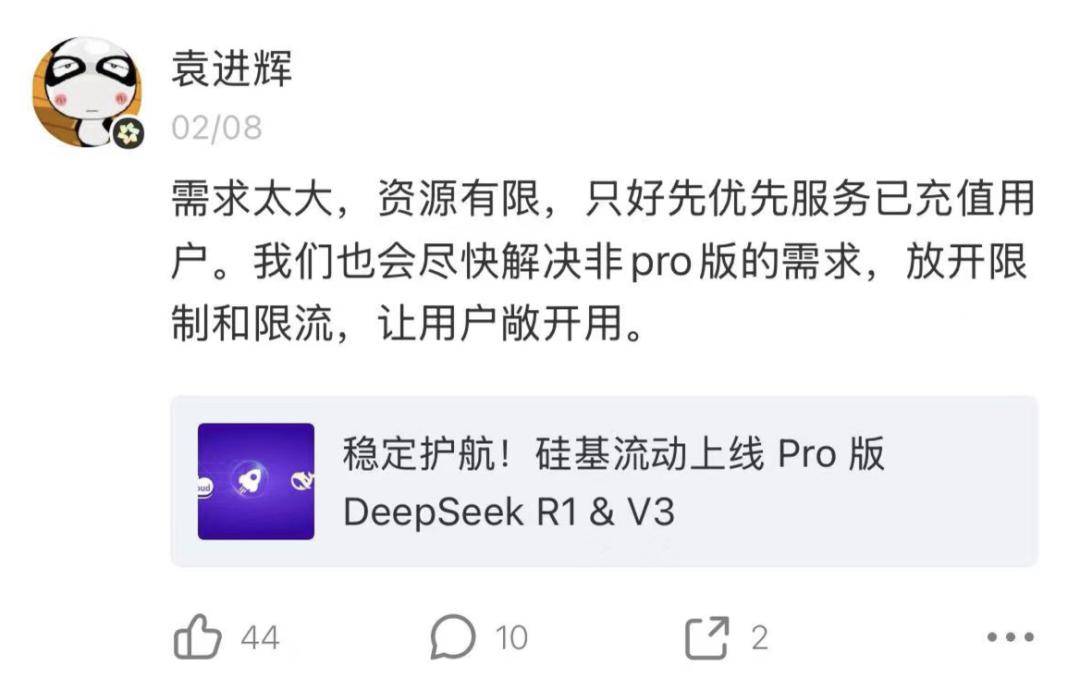

AI基础设施提供商硅基流动的创始人袁进辉曾在朋友圈复盘,DeepSeek出圈后,他们迅速与华为合作,完成了DeepSeek-R1和V3在昇腾生态的适配工作。与AI基础设施提供商同样敏锐的,还有国产芯片制造商。一位智算中心服务商表示,此轮DeepSeek热潮中,“国产AI芯片制造商反应迅速,几乎与英伟达等国际玩家同步接入。”

紧随其后的是云服务提供商和面向终端的软硬件制造商。云服务提供商方面,几乎所有“互联网云”都在春节期间上线了基于DeepSeek模型的API服务,打起了新一轮的“低API价格+开源模型战”,云端算力推动DeepSeek加速渗透不同行业。硬件方面,手机厂商也是最先拥抱DeepSeek的玩家之一,而在用户感受最直观的软件应用侧,包括腾讯在内的大厂携“超级应用+DeepSeek”卷入竞争,给大模型竞赛再添一把火。

在分食DeepSeek流量的背后,不同参与者各有打算。从算力层来看,拥有充足算力储备的云服务提供商动力更强。云服务提供商是中国算力市场的投资主力,对外大规模投资固定资产,包括采购芯片、服务器、租赁土地建数据中心等,对内也会自研芯片。以阿里和百度为例,2024年全年,阿里资本支出总计超724亿元,百度超82亿元。DeepSeek通过模型压缩、稀疏计算、混合精度训练等技术手段验证了低算力成本复现高性能模型的可行性,也给自研芯片的大厂带来了“自供血”机会。

“自供血、对外租赁,云服务提供商有自己的业务闭环。”一位行业专家表示。在战略层,BAT和字节跳动借DeepSeek可以达成两大目标:一是通过DeepSeek这一超级流量入口,与自身产品协同,短期承接DeepSeek的流量;二是有助于鞭策内部团队,在对比中提升自身模型能力。

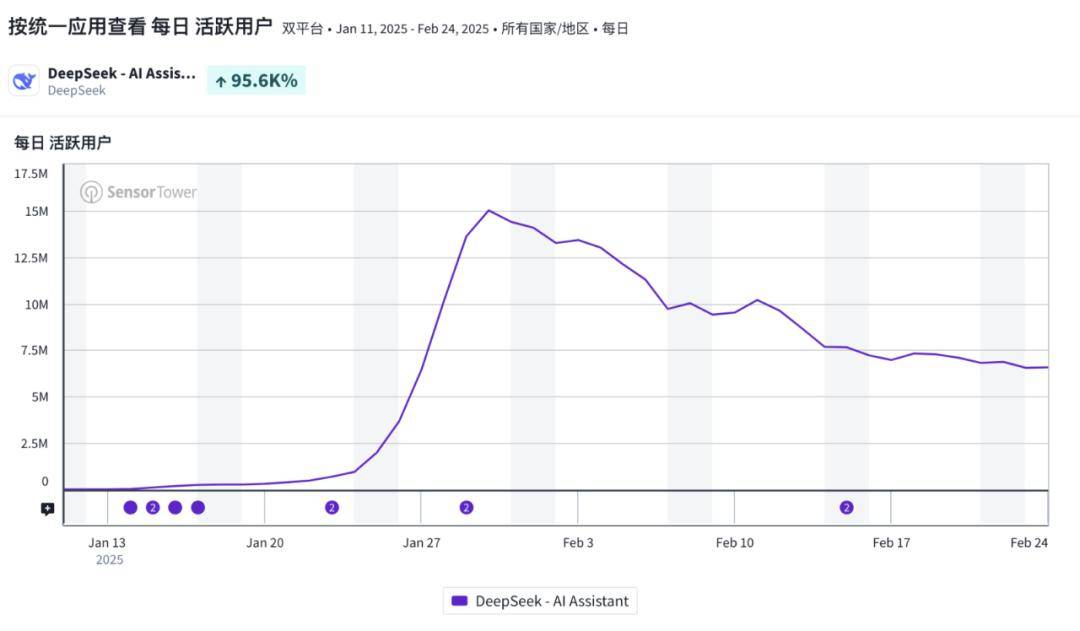

根据Sensor Tower的数据,截至2月24日,DeepSeek移动端的日活数据已从超过1500万的峰值下滑至700万左右。与之对应的是,其他大模型如元宝、豆包、通义等均实现了访问量和日活的大幅增长。DeepSeek的模型能力有目共睹,有流量有市场,且前期在C端以免费模式实现DAU的闪电式扩张,头部大厂自然会迅速跟进。

在应用侧,DeepSeek以低成本和低功耗支持复杂AI任务运行,推动AI进一步下沉至智能终端、汽车智驾和产业侧。以手机厂商为例,华为、荣耀、OPPO、vivo、魅族、努比亚等品牌宣布在AI助手接入DeepSeek。长期来看,手机厂商集体拥抱DeepSeek,一方面有利于其扩充云端AI生态,另一方面也有望不断拉动手机SoC需求量,在端侧、边缘侧诞生更多的软硬件升级。

伴随“接入DeepSeek”浪潮而来的,是服务器繁忙的提示。从用户直接体验来看,服务器繁忙、延迟加剧,就连硅基流动也不得不开始限流,寻求更多的算力资源。特别是当携带移动互联网时代超级应用入场的大厂加入,庞大的用户量更加剧了对算力的焦虑。

关于算力是否足够的问题,行业目前的共识是短期算力洗牌,长期算力短缺。“短期算力洗牌”指的是DeepSeek打破了过去模型厂商“大力出奇迹”的叙事,通过模型架构、预训练和推理侧的系统级工程手段,拉低了模型部署的算力门槛,短期内给国产芯片、算力服务商等整合国产算力、推动国产算力洗牌提供了机会窗口。

具体而言,一方面给国产芯片提供了更多机会;另一方面解决了部分智算中心算力闲置的困局。一直以来,强劲性能都是英伟达高端GPU的护城河,也是起步较晚的国产芯片的一大软肋。DeepSeek的出现一定程度上降低了对高性能芯片的依赖,作为采用MoE架构的大模型,DeepSeek对芯片训练性能的要求并不高,即便是像英伟达H20这样的性能阉割版GPU,也可以胜任DeepSeek的本地化部署需求。

而对一些部署国产芯片的智算中心而言,DeepSeek出圈也短期解决了算力闲置和碎片化问题。中国智算中心项目目前已超过600个,各地也在兴建千卡、万卡算力资源池。但在此之前,国产算力中心缺少一个成本低、性能好且开源的模型,导致很多算力没有得到有效利用。DeepSeek的出现带动了上下游生态,叠加政策驱动,推动过去闲置的国产算力真正地用起来。

然而,短期洗牌过后,长期来看,算力还是短缺的。训练和推理是AI芯片的主要任务场景,DeepSeek带动智能算力结构变化,推动Scaling Law向后训练、推理阶段转移。据IDC数据,2024年,中国智能算力规模达725.3百亿亿次/秒(EFLOPS),同比增长74.1%,增幅是同期通用算力增幅的3倍以上。未来智能算力内部训练算力占比会下滑,推理算力占比将上升。