在科技界的一次重大事件中,OpenAI于2月28日凌晨悄然发布了其最新的GPT-4.5模型。然而,这次发布并未如预期般收获满堂喝彩,反而引发了大量网友的吐槽,焦点主要集中在高昂的价格和迟缓的反应速度上。

网友@Colin Fraser通过实测发现,GPT-4.5在处理一道逻辑谜题时出现了严重错误,这无疑为这款新模型的口碑雪上加霜。价格方面,GPT-4.5的API定价高达每百万Tokens 75美元,这一价格不仅远超同类竞品DeepSeek R1,甚至比GPT-4的定价高出30倍之多。网友Casper Hansen直言不讳地表示:“GPT-4.5的定价非常高,如果这些模型没有显著改进,我会感到失望。”

此次OpenAI的发布会显得颇为仓促,甚至CEO奥特曼也未能现身,原因是他需要照顾刚出生的孩子。这种紧迫感的背后,或许与中国大模型技术的迅猛发展密切相关。

就在同一天,百度正式宣布将于3月16日上线文心大模型的最新版4.5。这款新版本不仅在基础模型能力上有了大幅提升,还具备了原生多模态和深度思考等先进功能。更令人瞩目的是,百度宣布将从6月30日起将文心4.5开源,这一举措无疑将为中国大模型技术的发展注入新的活力。

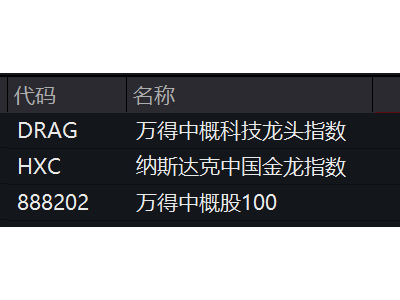

近期,DeepSeek发布的DeepSeek-R1大模型也引起了广泛关注。这款模型在数学、代码、自然语言推理等任务上的性能堪比OpenAI的GPT系列,更重要的是,它对算力资源的利用达到了极致,从而实现了成本的最小化。国外同行在《自然》杂志上对此惊叹不已:“这太疯狂了,完全出乎意料。”

在这场中美大模型的竞赛中,除了比拼基础能力外,对成本的控制和开源生态的建设也成为了关键因素。这些因素将直接决定大模型能否真正实现大规模落地应用。

过去,中国的大模型技术一直被视为OpenAI的追随者,从语言模型到多模态模型,再到推理模型,中国总是紧随其后。然而,如今这一局面正在发生深刻变化。著名人工智能研究学者、DeepLearning.AI创始人吴恩达在博客中指出:“中国在生成式AI领域正在赶超美国,甚至在视频生成等领域,中国似乎已处于领先地位。”

GPT-4.5的“失灵”正是中美大模型实力博弈的一个缩影。它反映出当前大模型领域的地位变迁——与那些开启狂卷模式的其他公司相比,OpenAI所能带来的技术突破越来越有限,且性价比极低。相比之下,国内大模型公司正以前所未有的速度发布新产品,展现出了强大的竞争力。

在这场由国内发起的大模型“第二场竞速”中,中国大模型界呈现出“百花齐放”的态势。DeepSeek不仅在性能上直追OpenAI的推理模型,还大幅降低了训练和推理成本。MiniMax的新模型则摒弃了海外公认的Transformer架构,采用了更利于上下文记忆的线性注意力机制。月之暗面的推理模型K1.6尚未正式发布,但已在基准测试平台LiveCodeBench上登顶第一,超越了OpenAI的GPT-3 mini。

在技术不断缩小甚至超越的基础上,中国大模型开始发挥自身的主场优势。对于那些从一开始就思考落地问题的大模型公司来说,谁能在技术优势的基础上找到落地场景的最优解,谁就能在这场应用卡位赛中脱颖而出。

百度作为大厂梯队中的一员,其在大模型之战中的表现尤为引人注目。2月13日,百度宣布文心一言将于4月1日起全面免费开放给所有PC端和APP端用户。在OpenAI大肆推进商业化、开售高价会员服务的背景下,百度的这一举措无疑展现了极大的诚意。

不仅如此,百度还计划将文心一言4.5开源。李彦宏深刻认识到,无论开源还是闭源,基础模型只有在大规模解决现实问题时才具备真实价值。因此,百度在追赶海外顶尖技术的同时,也跳出了固有的竞争框架,积极探索弯道超车的可能性。

春节后的一个月内,中国大模型市场掀起了一股DeepSeek接入潮。截至目前,已有近200家企业官宣将深度接入DeepSeek大模型产品。百度AI搜索、百度文库等C端产品以及B端的云厂商纷纷集成DeepSeek大模型,为客户提供相关API调用服务,并考虑推出私有化部署方案。

百度智能云千帆平台在接入DeepSeek-R1/V3模型后,上线首日即有超过1.5万家客户通过该平台进行模型调用。同时,百度智能云旗下的客悦、曦灵、一见、甄知四款大模型应用产品也正式上线了接入DeepSeek模型的全新版本。

在基础设施层面,百度也深度适配了DeepSeek。基于自研的昆仑芯P800,百度百舸发布了部署“满血版DeepSeek R1+联网搜索”的服务,能够为企业提供及时、准确的信息支持。针对企业私有化部署需求,百度智能云推出了DeepSeek一体机解决方案,在私有化部署层面搭载昆仑芯P800的百舸、千帆、一见一体机产品,可支持在单机环境下一键部署DeepSeek R1/V3全系列模型,提供开箱即用的便捷体验。

随着大模型技术的飞速发展,持续投入已成为确保技术创新的关键。李彦宏表示:“我们仍需对芯片、数据中心和云基础设施进行持续投入,以训练更好更智能的下一代模型。”为了实现这一目标,需要使用更多的算力来尝试不同的路径。

对于企业自身而言,前期研发成本投入是固定项,只有当技术真正投向应用并让更多用户使用时,才能实现规模经济优势。而扩大规模经济优势的同时,只有通过技术降本才能使免费和降价策略得以持续。李彦宏曾预言:“今天当我们谈论大型语言模型时,12个月内推理成本基本上可以降低90%以上成本,并且大模型的性能也会越来越好。”