近期,科技界迎来了一场前所未有的震撼,DeepSeek大模型的崛起让全球科技巨头纷纷侧目。在直播中,特斯拉CEO马斯克携手其最新力作——被誉为“地球上最聪明的AI”的Gork 3惊艳亮相,自诩其推理能力已超越所有现有模型,甚至在推理测试时间得分上力压DeepSeek R1和OpenAI的o1。这一消息犹如一枚重磅炸弹,瞬间引爆了科技圈。

不久之前,国民级应用微信宣布接入DeepSeek R1,并正处于灰度测试阶段。这一强强联合被视为AI搜索领域即将迎来翻天覆地变化的预兆。如今,微软、英伟达、华为云、腾讯云等全球众多科技大厂都已纷纷接入DeepSeek,其影响力可见一斑。

网友们更是脑洞大开,开发出算命、预测彩票等新奇玩法,使得DeepSeek的热度直接转化为经济效益,估值一路飙升,最高已达到千亿美金级别。DeepSeek之所以能迅速出圈,除了其免费且好用的特性外,还因为它仅以557.6万美元的GPU成本,就训练出了与OpenAI o1不相上下的DeepSeek R1模型。相比之下,过去几年的“百模大战”中,国内外AI大模型公司动辄投入几十亿甚至上百亿美元。

然而,Gork 3成为“全球最聪明AI”的代价同样不菲。马斯克透露,Gork 3的训练累计消耗了20万块英伟达GPU(单块成本约3万美元)。尽管如此,业内人士估算DeepSeek的GPU使用量仅在1万多张左右。不过,也有团队在成本上向DeepSeek发起挑战。李飞飞团队声称,仅用不到50美元的云计算费用,就训练出了一款在数学和编码能力测试中表现媲美OpenAI o1和DeepSeek R1的推理模型S1。但值得注意的是,S1为中型模型,与DeepSeek R1的上千亿参数级别存在显著差异。

在探讨DeepSeek的成功及其背后的成本问题时,首先需要澄清几个概念。DeepSeek并非仅有一个大模型,而是拥有多个不同功能的大模型产品。557.6万美元是其通用大模型DeepSeek-V3训练过程中的GPU花费,即净算力成本。通用大模型与推理大模型DeepSeek-R1在功能和技术上存在差异。通用大模型接收明确指令,拆解步骤,基于概率预测快速回答;而推理大模型则接收简单明了的任务,基于链式思维推理得出答案。

在从业者看来,尽管DeepSeek-R1备受瞩目,但并不意味着推理大模型一定比通用大模型高级。大模型领域专家指出,对于某些问题,如询问国家首都等简单任务,推理大模型可能不如通用大模型高效且准确。因此,建议在使用时根据任务复杂程度选择合适的模型类型。

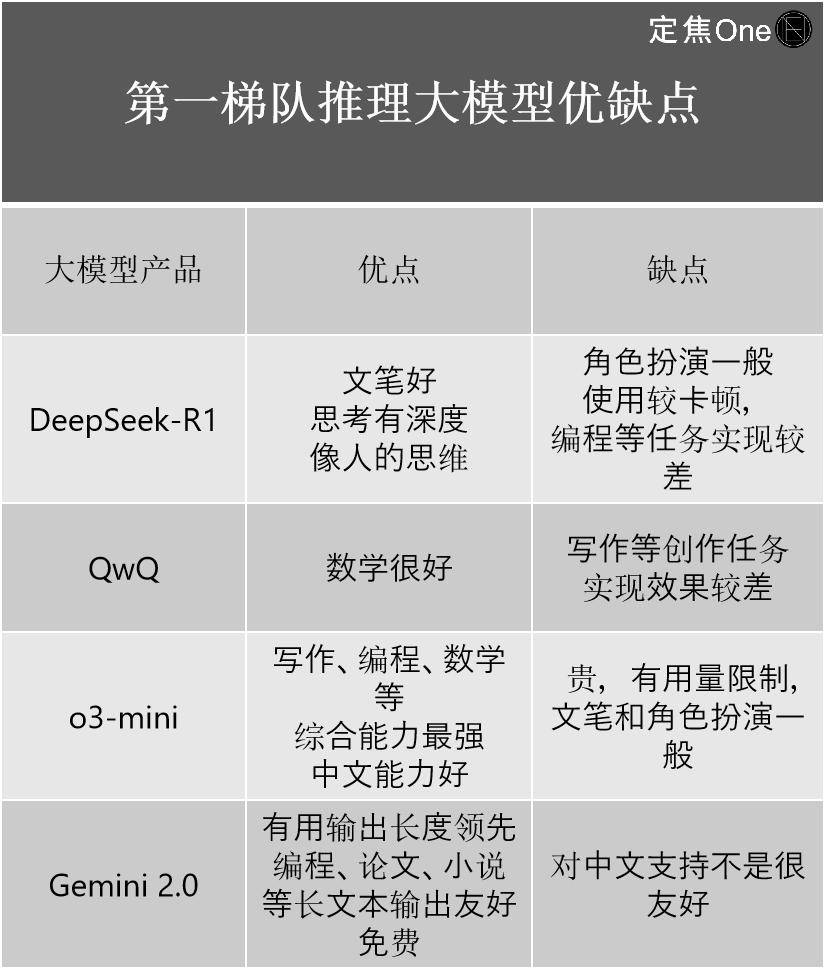

关于DeepSeek的真正实力,综合权威榜单和从业者评价,DeepSeek在推理大模型和通用大模型领域均占有一席之地。在推理大模型领域,DeepSeek-R1与OpenAI的o系列、Google的Gemini 2.0以及阿里的QwQ共同构成第一梯队。尽管外界认为DeepSeek-R1能力赶超OpenAI,但从技术角度看,与OpenAI最新的o3仍存在一定差距。然而,DeepSeek-R1的出现已大大缩小了国内外顶尖水平之间的差距。

在通用大模型领域,DeepSeek同样表现出色,与Google的Gemini、OpenAI的ChatGPT、Anthropic的Claude以及阿里的Qwen共同位列第一梯队。然而,DeepSeek也并非所有大模型都完美无缺。有专家发现,DeepSeek最新发布的多模态大模型Janus-Pro在使用效果上表现一般。

回到训练大模型的成本问题,大模型的诞生主要分为预训练和后训练两个阶段。无论是通用大模型还是推理大模型,国内外遵循的都是这一流程。成本差异主要集中在硬件、数据和人工三大方面。硬件方面,购买与租赁价格相差悬殊;数据方面,直接购买现成数据与人工爬取也存在显著差异。训练过程中的迭代版本数量也影响着总成本。

尽管外界曾根据GPU估算顶尖模型的训练成本,但由于闭源和算力浪费现象的存在,实际成本难以准确知晓。DeepSeek以557.6万美元的训练成本脱颖而出,但这一数字仅为模型总成本的一小部分。半导体市场分析和预测公司指出,考虑到服务器资本支出和运营成本等因素,DeepSeek的总成本在四年内可能达到25.73亿美元。即便如此,相较于其他大模型公司百亿美元的投入,DeepSeek的成本仍相对较低。

DeepSeek不仅在模型训练阶段效率更高,在调用推理阶段也展现出高效低成本的优势。从API定价来看,DeepSeek-R1的定价远低于OpenAI的o3-mini等竞品,使得中小企业更易于接入。DeepSeek的降本启示在于其在模型结构、预训练、后训练等各个环节都进行了优化。例如,采用细粒度专家分割和共享专家隔离提高MoE参数效率和性能;使用FP8低精度训练提高计算效率并降低硬件需求;在后训练中采用GRPO算法减少算力要求等。

DeepSeek的降本不仅给从业者带来了技术上的启发,也影响着AI公司的发展路径。英诺天使基金合伙人指出,AI产业在跑通AGI方向上存在两种不同路径选择:一种是“算力军备”范式,先堆技术、堆钱、堆算力提升性能再考虑产业落地;另一种是“算法效率”范式,一开始就以产业落地为目标,通过架构创新和工程化能力推出低成本高性能模型。DeepSeek的一系列模型证明了在性能天花板难以突破的情况下,将重点放在优化效率上的范式具有可行性。