自春节至元宵,AI芯片与算力领域的工程师们未曾停歇,他们的忙碌皆因一条名为DeepSeek的“鲇鱼”而起。这条“鲇鱼”以其低算力、高性能及开源特性,为国产AI算力的发展开辟了新的想象空间。

从大年初四至大年初十,短短数日内,十多家国产AI芯片与算力企业纷纷加入DeepSeek的“朋友圈”,工程师们紧锣密鼓地进行着模型的适配与服务上架工作。而时至今日,这些企业的重心已悄然转向——部署。

目前,行业正由DeepSeek的适配阶段向部署与应用阶段过渡。一方面,企业迎来了大量用户的咨询,全力响应用户需求;另一方面,它们也在积极打造DeepSeek版的智算一体机,以加速AI应用的落地。业内人士预计,到2025年,大模型的应用落地将迎来爆发。

回顾过去两年,ChatGPT的崛起带动了算力产业的飞速发展,英伟达也因此坐上了“国王宝座”。然而,国产算力厂商却一直在苦苦寻找出路。如今,DeepSeek的出现为它们打开了一扇窗,但能否借此一飞冲天,还需经受市场的考验。

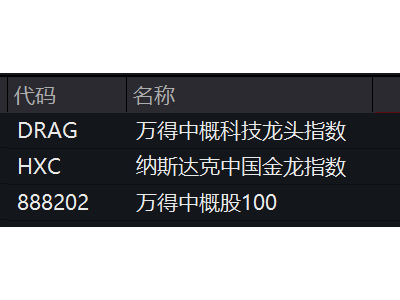

DeepSeek的火爆带动了推理算力需求的激增,行业或将迎来新一轮的洗牌。未来,性价比或将成为竞争的关键。2月13日,DeepSeek概念股午后再度拉升,多家相关企业股价大涨,市场反应热烈。

在适配方面,国产算力厂商的“适配潮”仍在持续。华为等领先企业已宣布联合推出基于DeepSeek的推理服务,但仍有大量工作在进行中。多数企业宣称能快速完成适配,但主要是DeepSeek的蒸馏模型,而原版模型的适配则更为复杂,对芯片的能力提出了更高要求。

在适配过程中,DeepSeek的模型可分为两类:一类是基于DeepSeek R1蒸馏的小参数模型,这些模型的适配相对简单,一般一周左右即可完成;另一类则是DeepSeek V3和R1的原版模型,这是DeepSeek自研的原生态MOE大模型,参数量巨大,对芯片的适应能力和执行效率提出了严峻挑战。

除了适配,部署更是关键。近期,多家企业纷纷表示正在忙于为客户做DeepSeek模型的部署工作。部署是模型转化为生产力的必要步骤,需要在用户的生产环境中进行模型的安装设置和与生产环境的连接。

为了推动DeepSeek的应用落地,多家企业推出了智算一体机这种硬件部署形式。这些一体机将DeepSeek模型与国产算力相结合,为用户提供了更加便捷、高效的AI应用解决方案。例如,摩尔线程与雪浪云联合打造的雪浪MindCenter X100就成功部署了DeepSeek的推理服务。

DeepSeek的火爆不仅带动了国产算力的发展,也引发了对算力市场未来格局的猜想。有业内人士认为,在DeepSeek模型的性能足够强且未来可能继续开源的情况下,企业可以直接使用它进行应用落地,而无需再重新训练基础模型。这将导致推理侧的算力需求大规模爆发。

随着生成式AI应用的落地,碎片化推理需求将大幅增加,市场规模有望超过训练。因此,国产GPU厂商应保持训练芯片的持续迭代,同时通过推理芯片快速切入商业化场景。未来,瞄准“训推一体”架构将成为行业发展的重要方向。

DeepSeek的出现为国产算力的发展带来了新的机遇与挑战。在激烈的市场竞争中,谁能抓住机遇、应对挑战,谁就能在AI算力领域占据一席之地。

随着DeepSeek应用的不断深入和拓展,国产算力将迎来更加广阔的发展前景。