随着人工智能技术的飞速发展,小语言模型(SLM)正逐渐崭露头角,成为推动AI应用创新的重要力量。这些小巧而高效的模型不仅能够直接部署在边缘设备上,如大型生产设备的传感器或物联网(IoT)设备,还能在实时数据收集与分析、设备监控和预测性维护等方面发挥巨大作用。

在车辆领域,SLM的应用同样引人注目。通过快速训练和紧凑的大小,这些模型能够在车载计算机上运行,结合多模态功能,将语音命令与图像分类相结合,帮助驾驶员识别障碍物,甚至利用RAG功能从高速公路法规或道路规则中检索信息,以做出更安全、更明智的驾驶决策。

SLM的兴起,挑战了AI模型开发中“越大越好”的传统观念。AI初创公司Cohere推出的R系列大语言模型中的Command R7B,就是面向注重速度、成本效率和灵活性的企业的典范。经过微调后,该模型可以部署在低端GPU、CPU甚至MacBook上,显著改善了部署成本与效率。

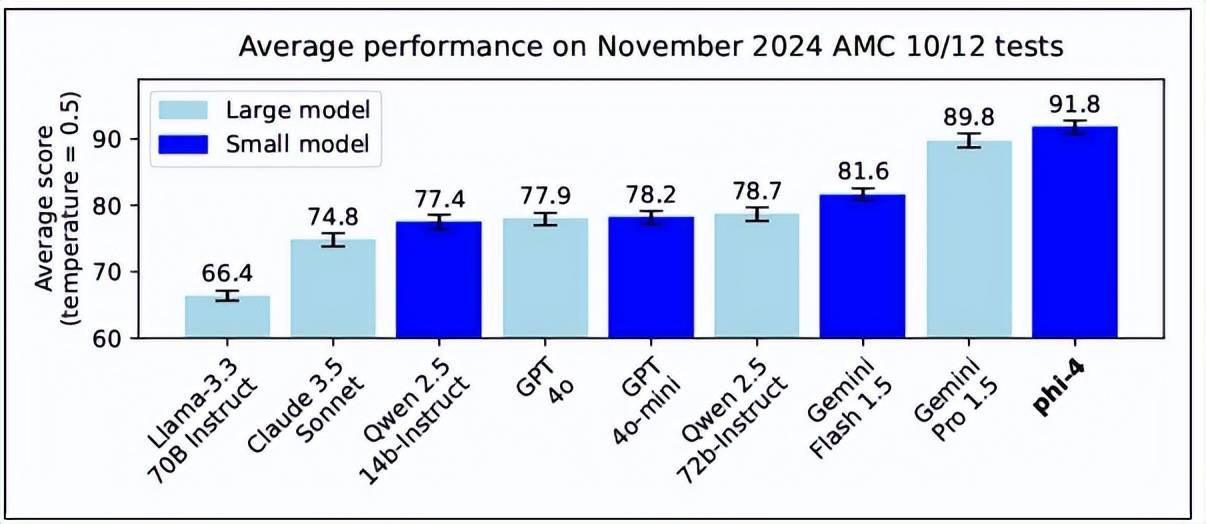

微软也不甘落后,推出了140亿参数的AI模型Phi-4,旨在优化性能的同时减少资源消耗。该模型在解决复杂数学问题上的表现甚至超越了许多大语言模型(LLM)。而DeepSeek R1推理模型在春节期间首次亮相后,以低廉的训练成本展示了卓越的性能,表明规模更小、更灵活的模型也能与AI巨头的大模型相媲美,甚至超越它们。

SLM之所以能够在AI领域掀起波澜,主要得益于其低成本、高效率的特点。这些模型通常参数较少,计算资源需求低,适合在资源受限的环境中部署,如边缘设备和移动应用。尽管在参数上不及LLM,但SLM在特定任务中却能实现令人印象深刻的性能,成为各种应用的宝贵工具。

例如,在开发通用聊天机器人时,LLM可能更合适,因为它们能够处理不同主题和复杂查询。然而,对于专注于特定产品线的专业客户服务机器人来说,SLM可能就足够了,甚至在某些方面优于LLM。SLM在隐私和安全控制方面也具有优势,可以部署在私有云计算环境或本地,从而更好地保护数据和管理网络安全威胁。

在模型压缩技术的推动下,SLM的性能得到了进一步提升。通过修剪、量化、低秩因式分解和知识提炼等方法,研究人员能够构建出更精简的模型,同时保持其准确性。这些技术不仅减少了模型的大小和计算需求,还提高了其训练和部署的效率。

SLM的广泛应用场景也是其受到青睐的重要原因之一。从边缘设备到实时应用程序,从隐私敏感域到嵌入式系统,SLM都展现出了巨大的潜力。它们能够在没有互联网连接的情况下离线完成AI推理,为各种设备提供智能支持。

微软在SLM领域走在了前列。其Phi系列模型从Phi-1发展到Phi-4,不断刷新着性能记录。Phi-4使用140亿参数处理复杂的数学运算,在基准测试中表现出色。而阿里巴巴发布的Qwen系列模型则以其先进高效的架构和多语言能力受到了广泛关注。这些模型不仅参数规模适中,还能够在多种语言任务中表现出色。

meta的Llama系列模型也是开源SLM中的佼佼者。Llama 2拥有340亿个参数,而较小的70亿参数的Llama 2 7B模型则专为研究目的设计。MobileLLaMA作为Llama的专门版本,旨在在移动和低功耗设备上表现出色。这些模型的出现为SLM的发展注入了新的活力。

当然,SLM也并非没有局限性。由于其参数较少,SLM在复杂理解能力上可能不及LLM。SLM的有效性还取决于其训练数据的质量,这在一定程度上限制了其应用范围。然而,随着技术的不断进步和模型的不断优化,这些局限性有望逐渐得到克服。

总的来说,SLM的兴起为人工智能领域带来了新的机遇和挑战。它们以低成本、高效率的特点赢得了市场的青睐,并在各种应用场景中发挥着重要作用。随着技术的不断发展,SLM有望在未来成为推动AI应用创新的重要力量。

在AI技术的浪潮中,SLM正以其独特的优势逐渐崭露头角。它们不仅为各种设备提供了智能支持,还为AI应用的创新和发展开辟了新的道路。随着技术的不断进步和应用场景的不断拓展,SLM的未来无疑将更加光明。