【ITBEAR科技资讯】1月26日消息,阿里云今日宣布在多模态大模型研究领域取得显著进展。据透露,通义千问的视觉理解模型Qwen-VL已经进行了重要升级,继之前的Plus版本后,再次推出了更为强大的Max版本。这一升级版模型在视觉推理和中文理解方面展现出了更为出色的能力,可以识别图片中的人物、回答问题、进行创作以及编写代码。在多个权威测评中,Qwen-VL-Plus和Qwen-VL-Max均取得了优异成绩,整体性能与GPT-4V和Gemini Ultra不相上下。

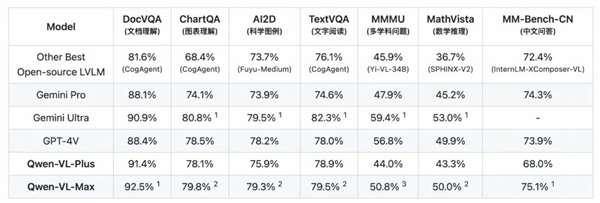

在各项评估中,Qwen-VL的两个升级版模型表现抢眼。它们在MMMU、MathVista等测评中远超业内其他开源模型,尤其在文档分析(DocVQA)和中文图像相关任务(MM-Bench-CN)上,更是超越了GPT-4V,达到了业界领先水平。这些模型不仅能够准确描述和识别图片中的信息,还能根据图片内容进行推理和创作,甚至具备了对画面指定区域进行问答的视觉定位能力。

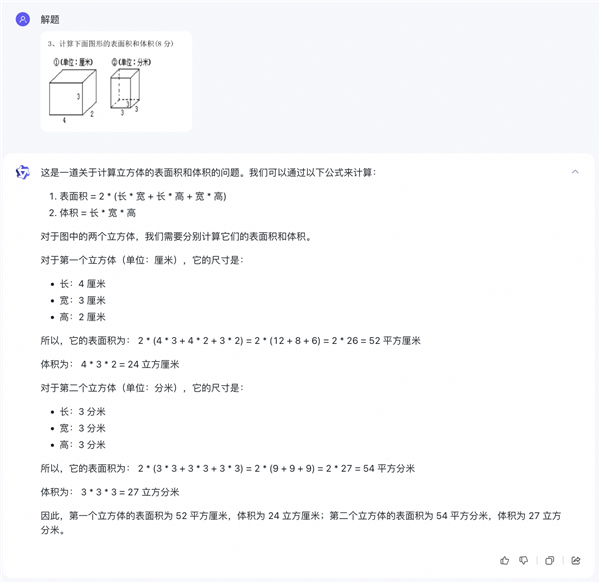

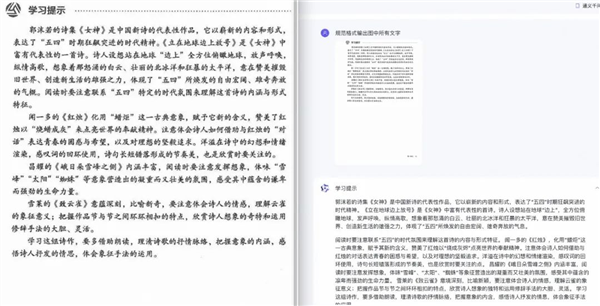

在视觉推理方面,Qwen-VL-Plus和Qwen-VL-Max展现出了强大的能力。它们能够理解流程图等复杂形式的图片,分析复杂图标,并且能够看图做题、看图作文、看图写代码。在图像文本处理方面,升级版Qwen-VL的中英文文本识别能力也得到了显著提升,支持处理百万像素以上的高清分辨率图和极端宽高比的图像,既能完整复现密集文本,也能从表格和文档中提取所需信息。

Qwen-VL-Max看图做题

据ITBEAR科技资讯了解,多模态是当前大模型领域最具共识的发展方向。过去半年来,OpenAI、谷歌等科技巨头纷纷推出了自己的多模态模型。阿里云也在2023年8月发布了具备图文理解能力的Qwen-VL模型,并将其开源。该模型在同期表现中远超同等规模的通用模型,展现了强大的实力。

Qwen-VL-Max复现密集文本

视觉作为多模态能力中最重要的模态之一,占据了人类感知和认知世界信息的80%。通义千问的视觉语言模型基于通义千问LLM开发,通过将视觉表示学习模型与LLM对齐,为AI赋予了理解视觉信息的能力。这一创新在大语言模型的基础上开辟了一扇视觉的“窗”,为AI带来了更广阔的应用前景。

与LLM相比,多模态大模型在应用方面拥有更大的想象力。研究者们正在探索将多模态大模型与自动驾驶场景相结合,为实现“完全自动驾驶”寻找新的技术路径。同时,多模态模型还可以被部署到手机、机器人、智能音箱等端侧设备中,让智能设备能够自动理解物理世界的信息。此外,基于多模态模型开发的应用还可以辅助视力障碍群体的日常生活,为他们提供更多的便利。

目前,Qwen-VL-Plus和Qwen-VL-Max已经限时免费开放给用户使用。用户可以在通义千问的官网和APP上直接体验Max版本模型的能力,也可以通过阿里云的灵积平台(DashScope)调用模型的API进行使用。