在AI技术日新月异的今天,一向以内容社区著称的小红书近期在AI领域迈出了重要一步。该平台宣布,其人文智能实验室(hi lab)已成功推出并开源了首个自研大模型——dots.llm1。

近日,小红书hi lab团队在Github和Hugging Face等平台上发布了dots.llm1,这一举措标志着小红书正式进军大模型开源领域。此次开源的内容相当全面,涵盖了微调Instruct模型、长文base模型、多个base模型的退火阶段版本、超参数配置,以及训练过程中的多个checkpoint,总数达到每1万亿个token。

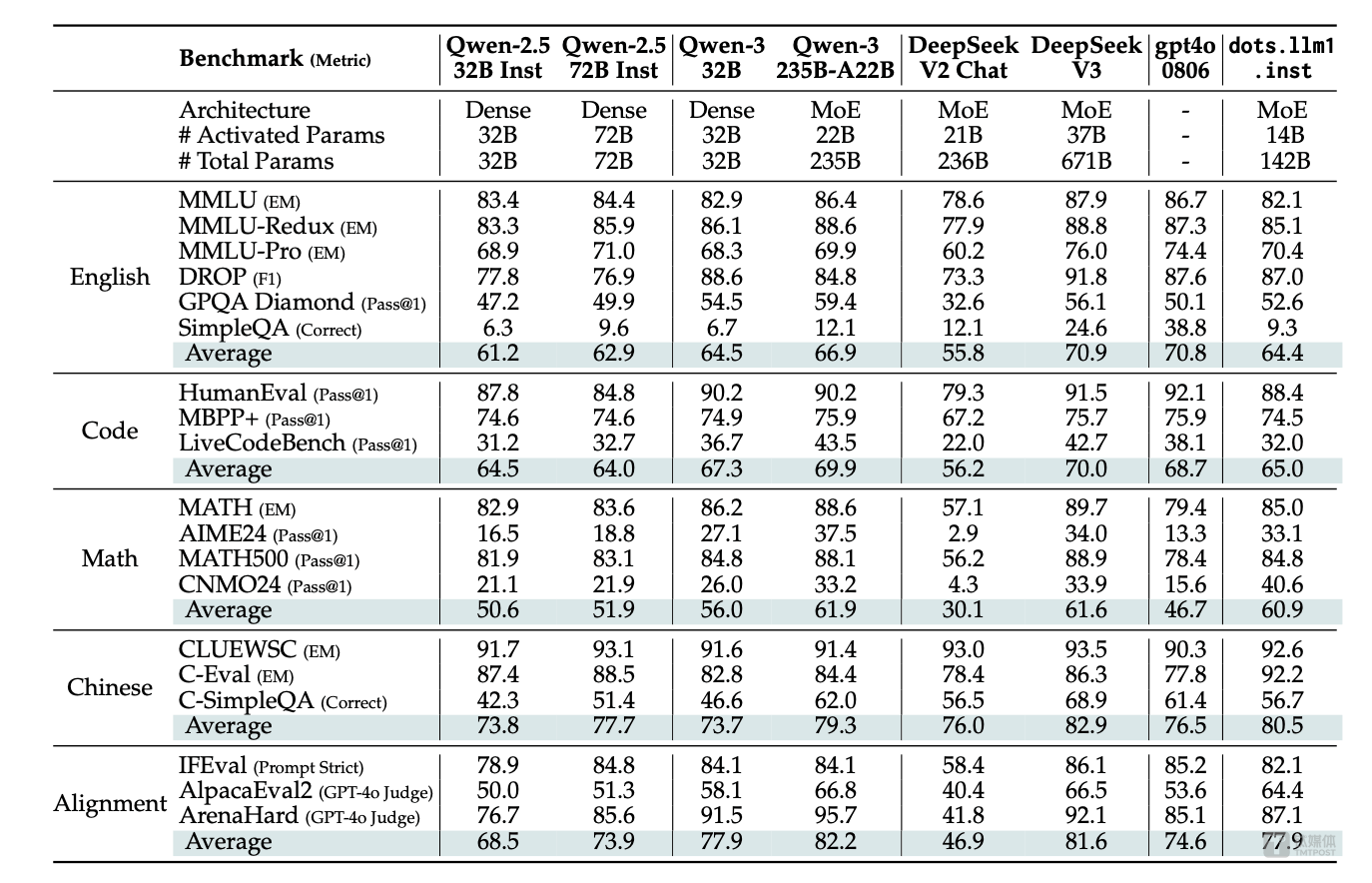

值得注意的是,dots.llm1在发布后不久便进行了更新,修复了停止符号的配置问题,这一常规修复进一步提升了模型的稳定性和可用性。据了解,dots.llm1的性能表现颇为亮眼,与阿里巴巴的Qwen 2.5模型在多个方面不相上下,部分性能甚至与Qwen 3模型相当。

dots.llm1采用了混合专家模型(MoE)架构,拥有惊人的1420亿参数。在训练过程中,该模型使用了高达11.2万亿token的高质量非合成数据,这些数据经过人工校验和实验验证,质量显著优于开源的TxT360数据。在推理阶段,dots.llm1仅需激活140亿参数,即可保持高性能,同时大幅度降低了训练和推理成本。

dots.llm1的研发过程经历了预训练和指令微调两个阶段。预训练阶段使用了大量高质量数据,并通过两阶段监督微调(SFT)训练,最终得到了base模型和instruct模型。其中,base模型作为基座模型,完成了预训练任务;而instruct模型则在此基础上进行了指令微调,便于直接部署和使用。

在MoE高效训练实践方面,小红书团队引入了Interleaved 1F1B with AlltoAll overlap技术,实现了通信与计算的最大重叠,并优化了Grouped GEMM。经过实测验证,该解决方案在前向计算中平均提升了14.00%,在反向计算中平均提升了6.68%,充分证明了其有效性和实用价值。

在性能表现方面,dots.llm1在中英文通用场景、数学、代码和对齐任务上均展现出强劲实力。与阿里通义Qwen2.5-32B/72B-Instruct相比,dots.llm1具备竞争力;同时,在中英文、数学和对齐任务上,其表现与阿里Qwen3-32B相当或更优。dots.llm1在中文任务中展现出显著优势,在CLUEWSC上取得了92.6分的高分,在中文语义理解方面达到业界领先水平。

小红书自2013年成立以来,一直保持着稳健的发展态势,是移动互联网创业浪潮中的佼佼者。近年来,随着AI技术的快速发展,小红书也加快了AI落地的步伐。2023年起,小红书持续投入研发大模型,并推出了AI搜索应用“点点”以及内置的“问一问”功能,为用户提供更加便捷的信息查询服务。

小红书的估值也在不断攀升。根据金沙江创投旗下的一份股份交易文件显示,小红书的估值已从200亿美元大幅跃升至260亿美元。这一估值不仅远超B站、知乎等上市公司,也逼近了快手的市值。小红书的老股报价已经达到了350亿美元,市场对其未来发展充满期待。

作为未来工作的一部分,小红书hi lab将继续致力于训练更强大的模型,并探索更高效的架构设计。同时,该团队还将加深对最佳训练数据的理解,并探索实现更接近人类学习效率的方法,以期从每个训练示例中最大限度地获取知识。小红书hi lab还计划为社区贡献更多更优的全模态大模型,推动AI技术的进一步发展和应用。