近日,AI领域迎来了两大重要进展。一方面,埃隆·马斯克旗下的xAI公司发布了名为Grok3的大型语言模型,凭借在多项测试中的卓越表现,迅速登顶大模型测评榜。另一方面,DeepSeek与Kimi团队则分别发布了两篇关于如何降低长文本计算量、提升训练效率的论文,聚焦于AI技术的降本增效。

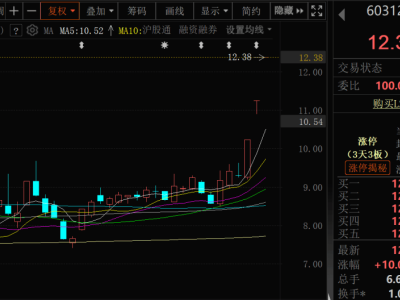

Grok3的发布无疑是AI界的一大震撼。据马斯克介绍,该模型采用了20万张英伟达H100芯片进行训练,性能强劲。在直播发布会上,xAI展示了其新建的数据中心,强调了大型算力集群对于智能提升的重要性。Grok3在大模型竞技场Chatbot Arena中的得分刷新了记录,凸显了其技术实力。这一成就不仅证明了“尺度定律”的有效性,也进一步提振了市场对算力供应商的信心,英伟达股价随之企稳回升。

然而,马斯克并未提及Grok3的开源计划。尽管他曾表示将在发布下一代模型后开源上一代模型,但Grok3目前依然是闭源的。这一做法与DeepSeek形成了鲜明对比。自DeepSeek爆火以来,其始终坚持开源模式,将技术研究免费分享给全球用户。近日,DeepSeek更是宣布将在未来一周内开源5个代码库,以完全透明的方式分享其进展。

在DeepSeek发布的论文中,提出了一种名为NSA的原生稀疏注意力机制。该机制通过压缩、选择和滑动的方式处理输入序列,减少了计算量,同时保持了模型性能。据DeepSeek介绍,NSA在基准测试中的得分优于传统全注意力模型,且计算速度显著提高。这一成果得到了业界的广泛认可,包括原谷歌顶级工程师Lucas Beyer在内的多位专家都给予了高度评价。

与此同时,Kimi团队也发布了一篇类似的论文,介绍了一种名为MoBA的块状混合注意力机制。该机制同样通过分割长文本并动态选择块的相关性来提高计算效率。值得注意的是,DeepSeek和Kimi的这两篇论文都强调了可以无缝集成到现有语言模型中,无需重新训练,这为现有大模型的加速提供了直接可行的方案。

面对DeepSeek和Kimi在降本增效方面的努力,马斯克及其xAI团队似乎并未受到影响。他们依然坚持通过扩大算力规模来提升模型性能。然而,这种做法也引发了业界对于性价比的讨论。有观点认为,尽管算力扩张能够带来性能提升,但高昂的成本并非所有企业都能承受。相比之下,DeepSeek的开源模式更有助于推动AI技术的普及和发展。

尽管Grok3目前是闭源的,但xAI近期宣布将免费提供Grok3的服务,直到服务器崩溃为止。这一举措或许能够吸引更多用户体验其强大的功能,但长远来看,开源模式仍然是推动AI技术发展的重要力量。DeepSeek的持续开源不仅有助于降低技术门槛,还能够促进全球范围内的技术创新和合作。

在AI技术日新月异的今天,中美两国的大模型发展路径呈现出明显的差异。美国企业更倾向于通过扩大算力规模来提升性能,而中国企业则更加注重降本增效和开源共享。这两种路径各有优劣,但最终的目标都是推动AI技术的普及和发展。未来,随着技术的不断进步和应用的不断拓展,中美两国在AI领域的竞争与合作将更加激烈。