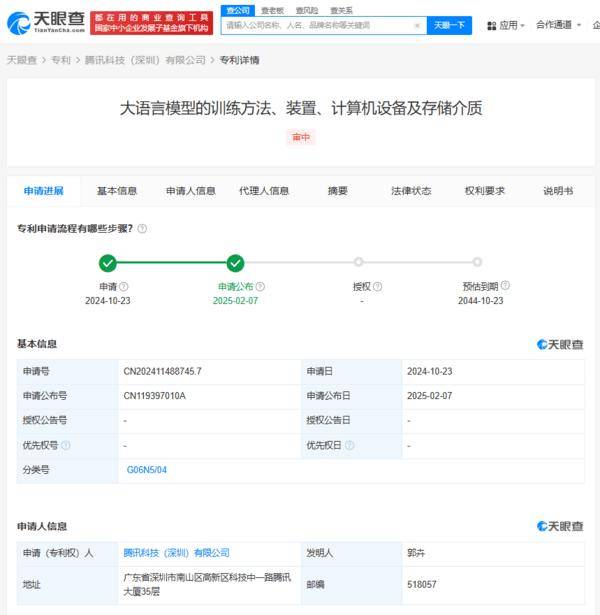

近日,腾讯科技(深圳)有限公司在大语言模型领域取得了一项重要突破,其申请的“大语言模型训练的创新方法、相关装置、计算机设备及存储介质”专利已正式对外公布。这项专利技术的核心在于引入了多重摘要文本的对比学习机制,显著提升了模型的泛化能力和生成内容的准确性,为AI语言处理技术的发展开辟了新的路径。

据专利摘要介绍,腾讯的新方法巧妙地设计了“第一摘要文本”与“第二摘要文本”的概念。这两类摘要文本在信息量上存在差异,且第一摘要文本中包含了正确与错误的语句混合。模型在训练过程中,通过对比这两种摘要文本,能够学习到如何区分正确的表达与错误的表达,从而有效减少了因单一数据源导致的过拟合问题。这一设计不仅极大地丰富了模型的学习维度,还通过动态调整策略,进一步提升了生成结果的可靠性和准确性。

值得注意的是,腾讯的这一新方法与近年来对比学习在文本摘要领域的应用趋势高度契合。对比学习通过构造正负样本,调整模型的表示空间,已在提升摘要质量、缓解暴露偏差等方面取得了显著成效。而腾讯此次将对比学习框架融入大语言模型的训练中,无疑进一步拓展了该技术的应用边界,为AI语言处理技术的发展注入了新的活力。

有媒体对此进行了深入分析,认为腾讯的这项专利通过多样化摘要文本及对比机制,为模型提供了一个更加贴近真实应用场景的学习环境。这对于智能客服、内容生成等需要高精度输出的领域来说,具有极其重要的意义。该技术还有望加速大模型在实际应用中的落地进程。例如,在短文本对话场景中,腾讯此前已推出了基于混合注意力机制的对话模型专利。若将这一新训练方法与之结合,无疑将进一步提升回复的相关性和丰富性,为用户提供更加优质的对话体验。

回顾腾讯近年来在大语言模型领域的布局,可以看出其野心勃勃。从2023年的微调方法专利到此次的训练框架创新,腾讯在大语言模型领域的技术积累日益深厚,形成了全链条的技术布局。这一系列的突破不仅展示了腾讯在AI技术领域的强大实力,也为整个行业的发展注入了新的动力。