随着人工智能技术的飞速发展,AI芯片的功耗和散热问题日益凸显,成为制约AI应用扩展的关键因素。高功耗不仅增加了企业的运营成本,还可能引发芯片过热、短路等风险,严重影响AI训练和推理的效率与效果。

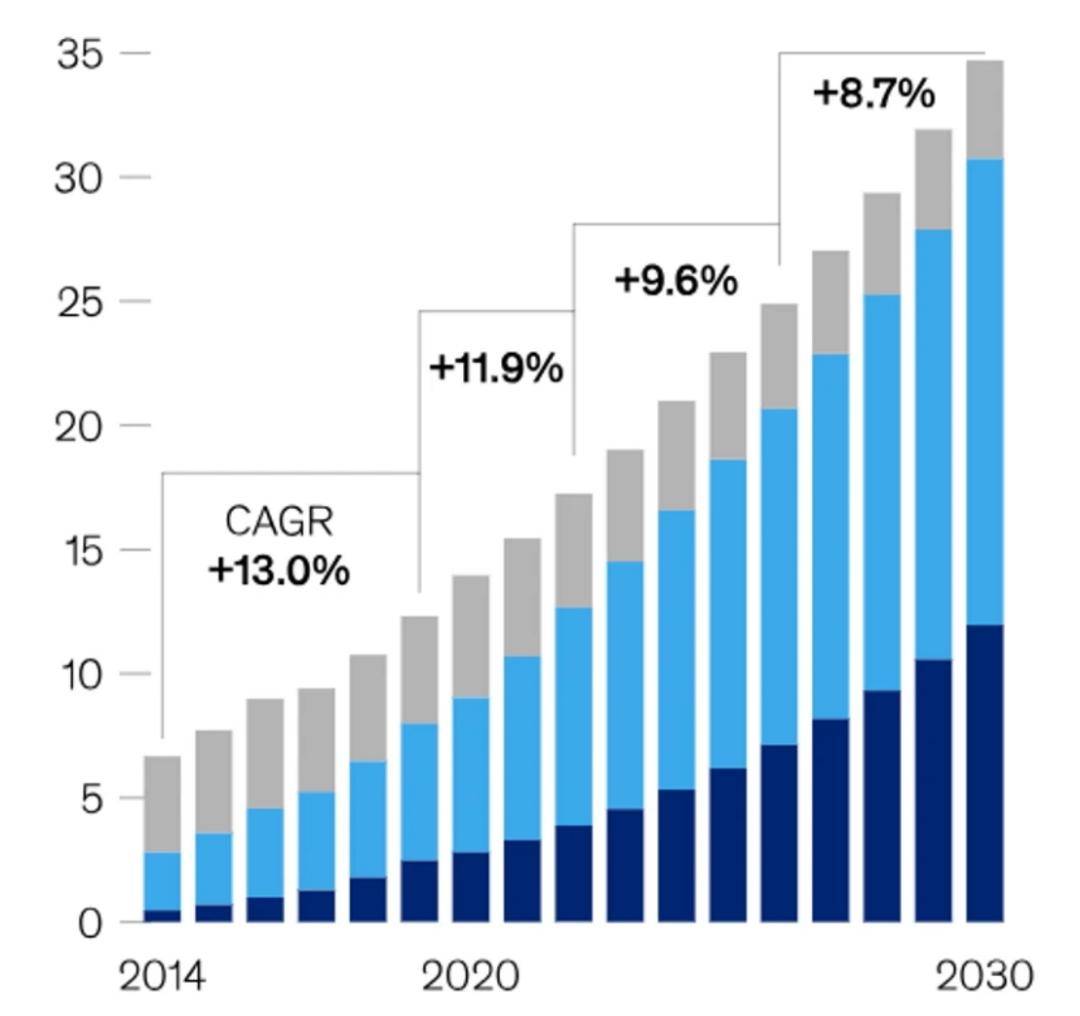

数据量的爆炸性增长进一步加剧了这一挑战。据统计,全球数据量从2015年的10EB预计将在2025年飙升至175ZB,到2035年更是可能达到2432ZB的惊人规模。边缘AI的发展需要在性能、功耗和成本之间找到完美的平衡点,尤其是在低功耗的电池供电设备中,如何在不推高成本的前提下提升算力,成为亟待解决的问题。

AI应用,如ChatGPT所使用的大型语言模型(LLM),依赖于“并行计算”,即由芯片网络同时执行多项计算任务。作为人工智能基础设施的核心,GPU擅长处理这类高性能并行计算工作,但其强大的处理能力也伴随着高能耗和高热量输出。高端GPU的功率密度约为CPU的四倍,这给数据中心的规划和运营带来了全新的挑战。

以Nvidia的A100和H100 AI芯片为例,A100的恒定功耗约为400W,而H100的功耗更是接近700W,与微波炉相当。如果超大规模数据中心采用这些高性能GPU替换现有的CPU服务器,所需功率将激增4-5倍,相当于一座核电站的供电量。功率密度的提升意味着散热需求也随之增加,传统的冷却系统已难以满足需求,数据中心的设计必须进行革新。

为了应对这一挑战,台积电推出了3DVC(三维均热板)技术,这是一种针对高性能计算和AI芯片的先进散热解决方案。与传统的二维均热板不同,3DVC通过立体化设计,在芯片封装内部集成多层微流体通道,利用相变传热原理快速导出热量。其内部采用三维毛细结构,增强工质的毛细回流能力,实现近结散热,有效缩短热传导路径。

3DVC技术不仅提高了散热效率,还实现了多维度散热,能够接触更多发热源并提供更多散热路径。台积电计划在AMD、NVIDIA的下一代产品中应用这一技术,与CoWoS-L封装技术同步推出,为CPU、GPU等提供一体化散热解决方案。

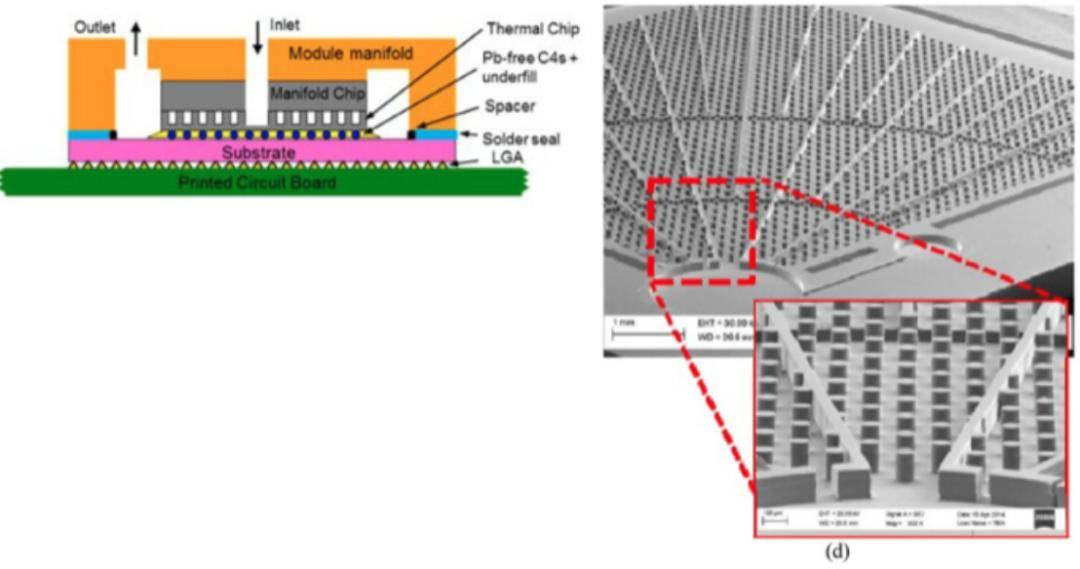

在液冷方面,高功率下的散热需求使得液冷成为唯一可行的解决方案。液冷的散热效率远高于空气,水的散热效率约为空气的3600倍。当芯片面积每平方厘米的散热量超过50瓦时,通常需要采用液冷。直接芯片冷却技术通过热界面将液体连接到芯片散热器的冷板通道流动,实现高效散热。浸入式冷却技术和嵌入式微通道相变冷却技术也是解决高功耗散热问题的有效途径。

英伟达在AI硬件领域也取得了显著进展。其发布的Blackwell超级芯片标志着AI硬件迈入新纪元。基于Blackwell的DGX GB200服务器结合了36颗NVIDIA Grace CPU和72块Blackwell GPU,通过第五代NVLink连接成一台超级计算机,提供前所未有的计算支持。为了应对高功耗问题,英伟达采用了全新的液冷机架规模架构,通过DGX GB200 SuperPod超级计算集群,为各行各业提供强大的AI计算能力。

NVLink作为一种高速互联技术,允许GPU之间以点对点方式进行通信,实现更高的带宽和更低的延迟。在DGX GB200中,NVLink连接了多个GPU和CPU,形成了强大的计算网络,为处理复杂AI模型提供了有力支持。例如,GB200 NVL72服务器提供了720 petaflops的FP8性能和1440 petaflops的FP4计算性能,可处理多达27万亿个AI LLM参数模型。

随着AI技术的不断发展,功耗和散热问题将持续受到关注。各大厂商和科研机构正不断探索新的散热技术和解决方案,以应对日益增长的算力需求带来的挑战。未来,我们有望看到更多创新技术的涌现,为AI技术的普及和规模化应用提供有力支撑。